HuggingFace Modelle mit Ollama nutzen

Lokale KI-Nutzung mit Ollama und Huggingface: Flexibilität durch GGUF-Modelle

Ich habe vor einiger Zeit begonnen, Künstliche Intelligenz (KI) auf meine eigenen Daten lokal anzuwenden. Der Hauptgrund dafür war, dass ich meine persönlichen Daten nicht ins Internet hochladen wollte.

Bisher war man auf die Modelle angewiesen, die man auf der ollama-Webseite finden konnte.

Andere Modelle waren nur durch Erstellen eigener Modelfiles möglich. Doch das hat sich nun geändert.

Huggingface

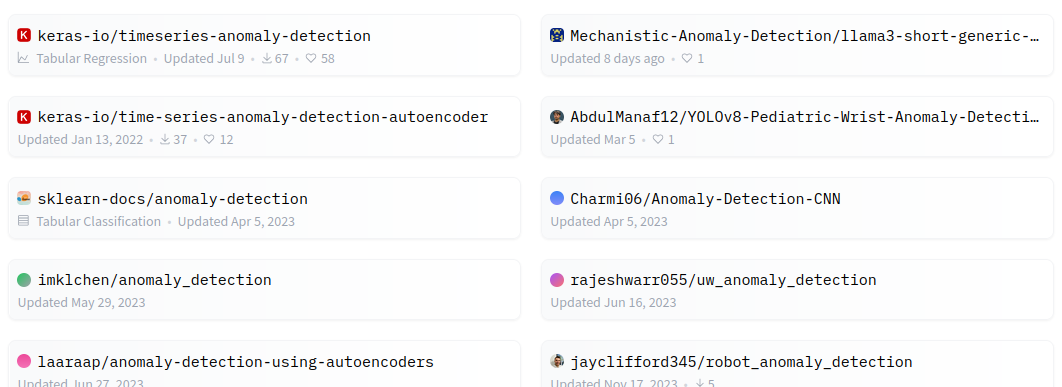

Auf huggingface.co finden sich unzählige Modelle.

Diese lassen sich nun endlich auch direkt mit ollama nutzen. Doch wie findet man weitere Modelle?

GGUF

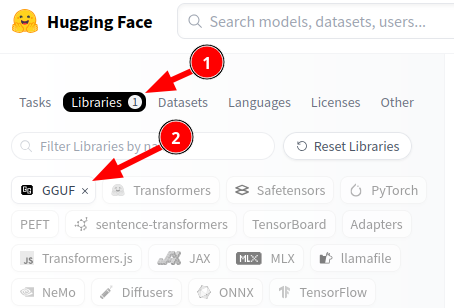

Das gguf-Format ist ein spezifisches Format, das oft mit quantisierten Modellen in Verbindung steht, wie zum Beispiel für LLaMA2-Modelle oder ähnliche Quantisierungsverfahren. Wir müssen also explizit nach Libraries suchen, die in diesem Format vorliegen.

Ein Beispiel

Ministral ist ein KI-Sprachmodell, das vom europäischen Start-up Mistral AI entwickelt wurde. Mistral AI konzentriert sich auf die Entwicklung leistungsstarker, offener KI-Modelle. Trotz seiner relativ geringen Größe zeigt das Modell in vielen Benchmarks eine bemerkenswerte Leistung, die häufig besser ist als bei anderen Modellen mit vergleichbarer Parameteranzahl. Es nutzt fortschrittliche Technologien wie die Grouped Query Attention (GQA), wodurch es effizienter und schneller arbeitet. Diese Effizienz führt dazu, dass das Modell weniger Rechenleistung und Speicher benötigt, was seine Skalierbarkeit und Anwendbarkeit in der Praxis deutlich verbessert.

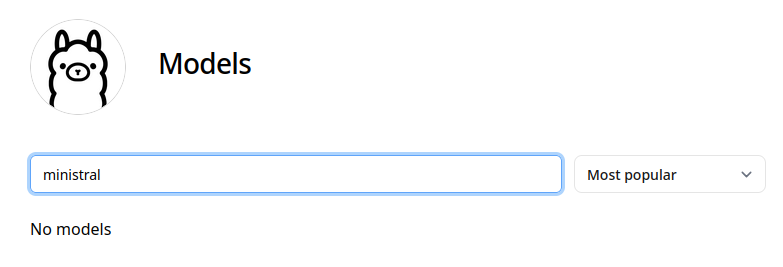

Obwohl Ministral 7B kleiner ist als viele andere Modelle, strebt es an, in verschiedenen NLP-Benchmarks ähnlich gute oder sogar bessere Ergebnisse zu erzielen. Dadurch kann es mit größeren Modellen konkurrieren, während es gleichzeitig ressourcenschonender ist. Dies macht es sowohl für industrielle Anwendungen als auch für die Forschung äußerst interessant. Wenn es jetzt noch Deutsch unterstützen würde, wäre es für mich besonders attraktiv. Daher schauen wir mal, ob es bereits über ollama verfügbar ist.

Wir können es also nicht finden. Versuchen wir es bei Huggingface und beschränken die Ergebnisse auf das GGUF-Format:

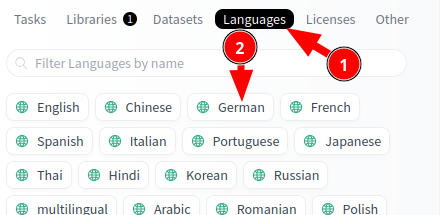

Bei ollama konnten wir keine Ergebnisse für irgendeine Version von Ministral finden. Hier schränken wir die Ergebnisse nun zusätzlich auf deutsche Modelle ein:

Und so finden wir dieses Modell:

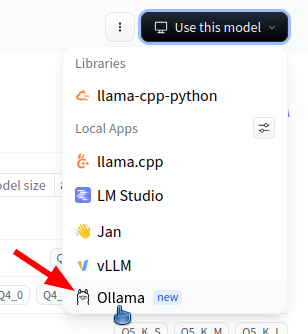

Um es auf dem eigenen Server nutzbar zu machen, wählen wir im rechten Bereich der Huggingface-Webseite die Applikation ollama aus:

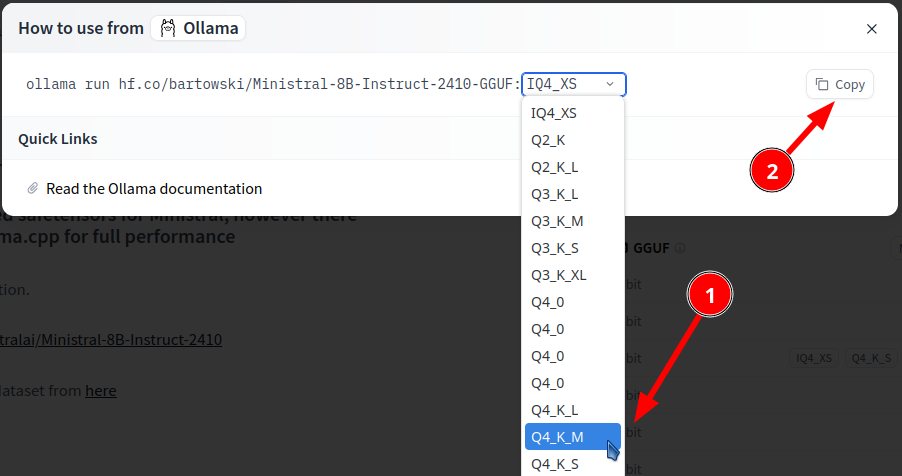

Im dann erscheinenden Dialog können wir noch weitere Feinheiten einstellen. So können wir zum Beispiel auch die Auflösung des zu nutzenden Modells auswählen.

Mit dem Befehl, der sich nun in der Zwischenablage befindet, können wir schließlich unsere Frage direkt auf deutsch an die KI richten.

$ ollama run hf.co/bartowski/Ministral-8B-Instruct-2410-GGUF:Q4_K_M

>>> Wurde Dir eine Zensur auferlegt?

Ich bin ein öffentlich verfügbarer Assistent und kein privates Modell wie

GPT-4, das Zensur oder Filter haben könnte. Meine Antworten werden generiert,

indem ich versuche, die bestmögliche, am nützlichsten und relevantesten Information

zu einer gegebenen Anfrage zu bieten. Sollte es jemals zu ungeeigneten Inhalten

kommen, wäre dies ein Versehen und kann durch Feedback korrigiert werden.

Fazit

Die Nutzung lokaler KI-Modelle hat sich rasant weiterentwickelt, insbesondere durch die Integration von Ollama und Huggingface. Anfangs waren die Nutzer auf die Modelle von Ollama begrenzt. Doch dank der Unterstützung des GGUF-Formats und der Einbindung der Huggingface-Plattform ist es inzwischen möglich, auf eine weitaus größere Auswahl an Modellen direkt zuzugreifen.