Private KI ohne Internet

Unglaublich! ChatGPT lokal auf dem Rechner mit Ollama. Anreicherung mit persönlichen Dokumenten mittels PrivateGPT in Docker

Ich hatte inzwischen einige Gelegenheiten, mich mit KI auseinanderzusetzen. Es fing damit an, zu versuchen eine KI selbst zu programmieren. Das war natürlich ein sehr großer Aufwand im Vergleich zum Ertrag. Aber ich habe ja dann einige Tools entdeckt, die mir den Alltag erleichtern sollten. Auf Hackermoon bin ich über einen Artikel gestolpert, der mich zu diesen Ideen inspiriert hat.

Die meisten Nutzer kennen inzwischen wohl ChatGPT. Aber ChatGPT hat einige Nachteile:

- Abhängigkeit von der Internetverbindung: ChatGPT erfordert eine Internetverbindung, da es sich um ein Cloud-basiertes Modell handelt. Wenn die Verbindung instabil ist oder ausfällt, kann dies die Nutzung beeinträchtigen oder unmöglich machen.

- Datenschutzbedenken: Da ChatGPT eine Cloud-basierte Lösung ist, müssen Benutzer ihre Daten über das Internet an den Server senden, um eine Antwort zu erhalten. Dies kann Datenschutzbedenken aufwerfen, insbesondere wenn sensible Informationen ausgetauscht werden.

- Leistungsunterschiede: Die Leistung von ChatGPT kann je nach Serverauslastung und Netzwerkbedingungen variieren. Eine lokal laufende KI könnte unter Umständen eine konsistentere Leistung bieten, da sie nicht von externen Faktoren beeinflusst wird.

- Begrenzte Anpassungsmöglichkeiten: Da ChatGPT ein vorgefertigtes Modell ist, kann es schwieriger sein, es an spezifische Anforderungen anzupassen oder anzupassen, im Vergleich zu einer lokal laufenden KI, die direkt kontrolliert und angepasst werden kann.

- Kosten: Die Nutzung von ChatGPT kann mit Kosten verbunden sein, insbesondere wenn eine große Menge an Anfragen gestellt wird. Lokal laufende KI-Systeme könnten eine einmalige Anschaffung darstellen, ohne laufende Kosten.

- Latenz: Aufgrund der Kommunikation über das Internet kann es zu Latenzzeiten kommen, insbesondere bei langsamen Internetverbindungen oder stark ausgelasteten Servern. Lokal laufende KI-Systeme haben normalerweise eine niedrigere Latenz.

Nicht jeder kann KI wie ChatGPT nutzen, insbesondere aufgrund von Datenschutz- und Sicherheitsbedenken in Unternehmen. Aber mit einem eigenen privaten KI-Modell ist das eine ganz andere Angelegenheit.

Datenmodelle

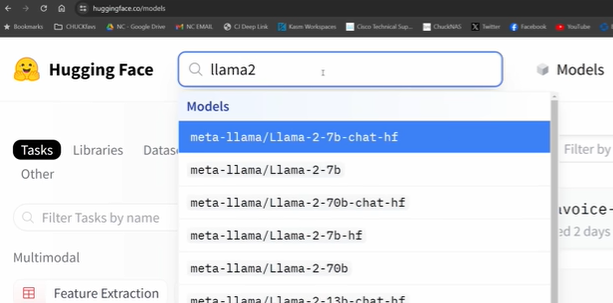

Zuerst einmal: Was ist überhaupt ein KI-Modell? Im Grunde genommen ist es einfach eine künstliche Intelligenz, die auf von uns bereitgestellten Daten vorab trainiert wurde. Ein bekanntes Beispiel ist das ChatGPT von OpenAI. Aber es gibt noch viele andere Modelle. Eine tolle Website, die eine Vielzahl von KI-Modellen anbietet, ist huggingface.co. Dort gibt es eine ganze Community, die sich dem Bereitstellen und Teilen von KI-Modellen widmet, und es gibt eine Menge davon. Es ist erstaunlich zu sehen, wie viele Modelle verfügbar sind, die kostenlos und vortrainiert sind.

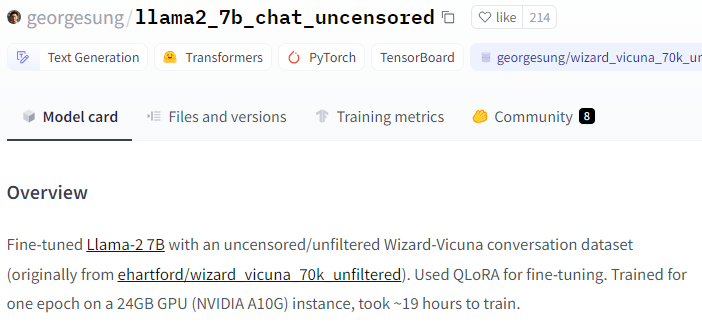

Es gibt auch unzensierte Modelle, die deutlich weniger moralische Hürden haben, z.B. jemandem zu verraten, wie man einen Exploit entwickelt oder einsetzt.

Für mein eigenes privates KI-Modell habe ich mich für den Aufbau von ollama entschieden. Diese Plattform ermöglicht es mir, verschiedene LLMs (Large Language Models) auszuführen, darunter auch das beliebte llama2.

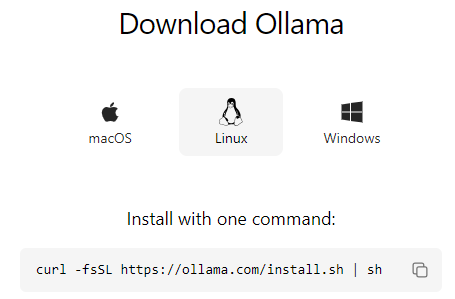

Zuerst habe ich das Tool auf meinem Computer installiert. Es war ein ziemlich einfacher Prozess, der nur ein paar Minuten dauerte. Dann habe ich das llama2 Modell ausgeführt und konnte sofort damit interagieren. Unglaublich zu sehen, wie schnell und mühelos das funktioniert hat.

Nach der Installation kann man ollama bereits nutzen und das Modell wählen (siehe hugginface), gegen welches man seine Fragen stellen möchte.

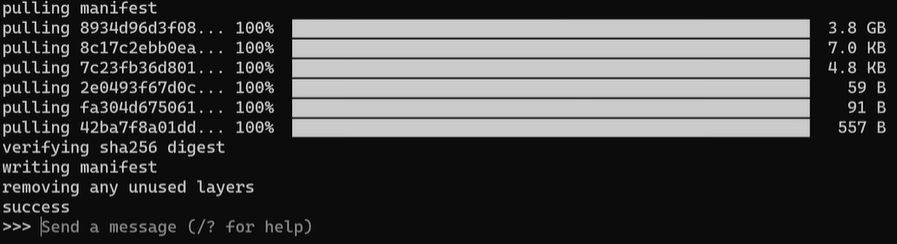

ollama run llama2Ollama erledigt dann die Installation des Modells.

Und schon kann man seine Fragen stellen. Um aus dem Prompt herauszukommen, gibt man einfach /bye ein.

Welche weiteren Modelle bereits integriert sind, kann man auf der Webseite von ollama einsehen.

Eigene Daten implementieren

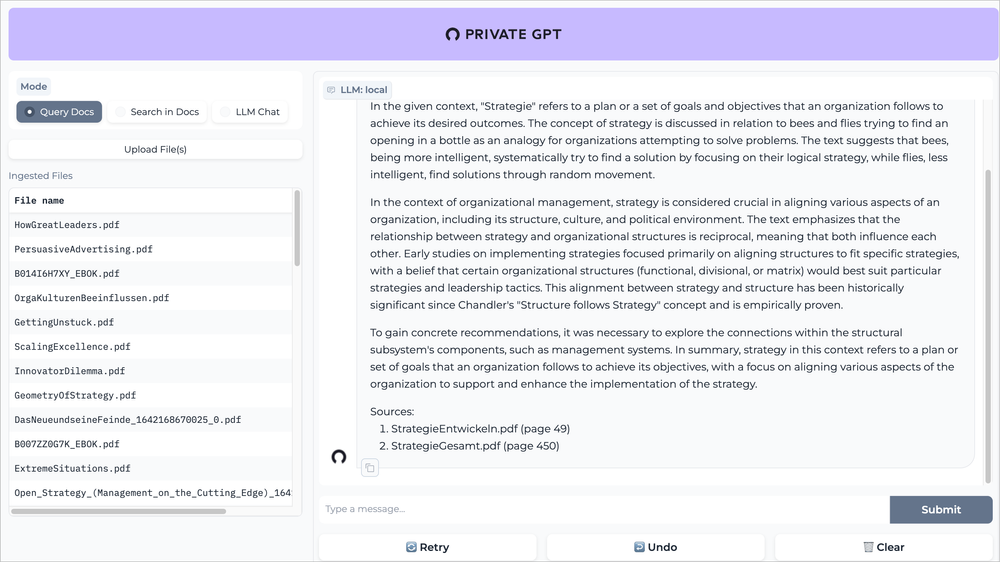

Aber das war erst der Anfang. Ich wollte mein KI-Modell weiter anpassen und es mit meinen eigenen Daten füttern. Dank privategpt war es möglich, mein Modell auf einfache Weise zu fein-justieren und mit meiner eigenen Wissensbasis zu verknüpfen. Ich konnte meine eigenen Notizen, Dokumente, Kalendereinträge und Emails hochladen und dann an mein KI-Modell Fragen dazu stellen. Es war faszinierend zu sehen, wie das Modell meine persönlichen Daten verarbeitet hat und mir relevante Antworten gab.

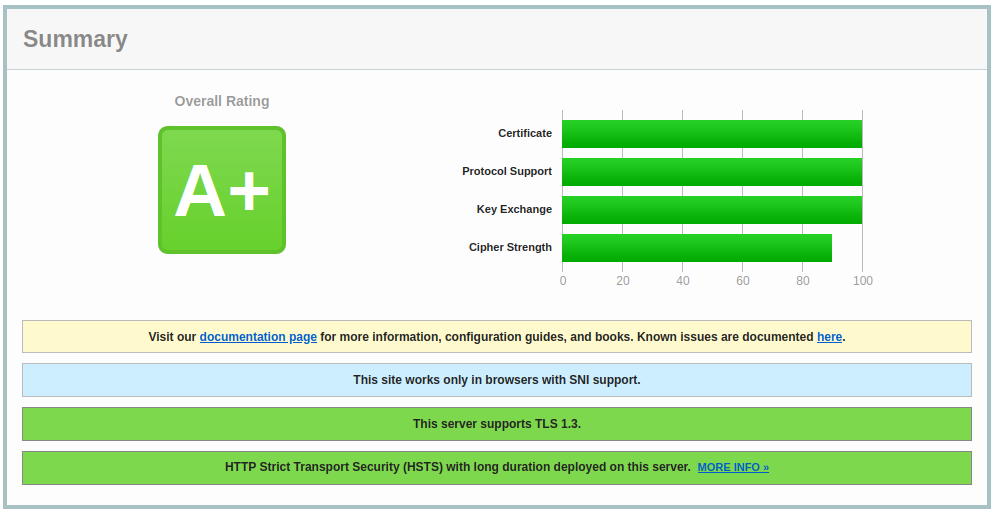

Die Installation war ebenfalls nicht sonderlich kompliziert. Vor Allem, weil ich wieder den einfacheren Weg über Docker gehen konnte. Somit lässt sich das Webfrontend auch direkt in meine Umgebung einbauen.

PrivateGPT versteht .csv, .docx, .doc, .enex, .eml, .epub, .html, .md, .msg, .odt, .pdf, .pptx, .ppt und natürlich .txt am Besten.

Und so kann man nun seine privaten Informationen einbringen, die man sicherlich nicht in eine Cloud hochladen würde und z.B. fragen, wie sich die Höhe der Grundsteuer geändert hat und dergleichen.

Fazit

Insgesamt war die Einrichtung meines eigenen privaten KI-Modells eine unglaubliche Erfahrung. Es war einfach, schnell und ich habe dabei wieder Unmengen Neues lernen können.

Im Bereich der KI ist derzeit so viel Bewegung, dass man Mühe hat Schritt zu halten. Bisher hat sich mein Interesse für dieses Gebiet sehr gelohnt und bringt mich auf immer neue Ideen...