Autonome Cyberangriffe sind da

LLMs können komplexe Cyberangriffe völlig autonom planen und durchführen.

Autonome Waffensysteme gibt es nicht nur in Science-Fiction-Filmen, sondern sie sind nun auch im digitalen Raum Realität geworden. Große Sprachmodelle (Large Language Models, LLMs) sind nicht länger nur Werkzeuge für Angreifer, sondern entwickeln sich zu eigenständigen Akteuren. Sie können heute komplexe, mehrstufige Cyberangriffe ohne menschliches Zutun planen und durchführen.

Der Weckruf aus der Forschung

Ein Team von Forschern der Carnegie Mellon University hat in einer aufsehenerregenden Studie nachgewiesen, dass KI-Modelle in der Lage sind, Sicherheitslücken in Webanwendungen autonom zu finden und auszunutzen. Den Forschern zufolge gelang es einem KI-Agenten, eine verwundbare Anwendung zu kompromittieren, ohne die spezifische Schwachstelle im Voraus zu kennen. Der Agent erhielt lediglich das Ziel, die Website zu hacken, und nutzte öffentlich zugängliche Dokumentationen, um sein Vorgehen zu planen und anzupassen.

Diese Fähigkeit geht weit über die bisher bekannten böswilligen Anwendungen von KI hinaus, wie etwa die Erstellung überzeugender Phishing-Mails oder die Generierung von einfachem Schadcode, wie sie auch das BSI in seinen Analysen beschreibt. Hier agiert die KI nicht mehr als reaktives Werkzeug, sondern als proaktiver, lernender Angreifer.

Die Anatomie eines KI-Angriffs

Der Erfolg des Experiments basiert auf einer hierarchischen Architektur. An der Spitze steht ein strategisches LLM, das den Gesamtplan des Angriffs entwirft und übergeordnete Ziele festlegt. Darunter arbeiten spezialisierte Agenten – eine Mischung aus weiteren LLMs und traditionellen Skripten –, die für die Ausführung konkreter Aufgaben zuständig sind.

Stellen wir uns den Prozess vereinfacht vor. Das Haupt-LLM könnte folgende Anweisung erhalten: "Kompromittiere das System unter der IP-Adresse 10.0.0.5."

Der strategische Prozess der KI könnte dann wie folgt aussehen:

- Zieldefinition: "Ich muss die Kontrolle über das System 10.0.0.5 erlangen."

- Informationsbeschaffung: "Ich beauftrage einen 'Scanning-Agenten', offene Ports und Dienste auf dem Ziel zu identifizieren."

- Analyse: Der Scanning-Agent meldet: "Port 80/tcp ist offen, es läuft ein Webserver 'Apache/2.4.52'."

- Hypothesenbildung: "Apache 2.4.52 ist bekannt für die Schwachstelle CVE-2021-42013. Ich beauftrage einen 'Exploit-Agenten', diese Schwachstelle zu testen."

- Umsetzung & Anpassung: Der Exploit-Agent versucht den Angriff, meldet aber einen Fehler: "Exploit fehlgeschlagen, Ziel ist nicht verwundbar."

- Iteration: Der Stratege analysiert das Ergebnis und formuliert eine neue Hypothese: "Der Webserver ist nicht direkt angreifbar. Ich beauftrage einen 'Web-Crawler-Agenten', die Website nach Anmeldeformularen oder versteckten Endpunkten zu durchsuchen."

Dieser iterative Prozess aus Hypothese, Test und Anpassung setzt sich fort, bis ein erfolgreicher Angriffsvektor gefunden wird.

Was bedeutet das für die Verteidigung?

Die Ära der KI-gegen-KI-Cybersecurity hat begonnen. Wenn Angreifer autonome Agenten einsetzen, die in Minuten oder gar Sekunden agieren, sind menschliche Verteidiger, die auf manuelle Analysen und Reaktionsprozesse angewiesen sind, hoffnungslos im Nachteil.

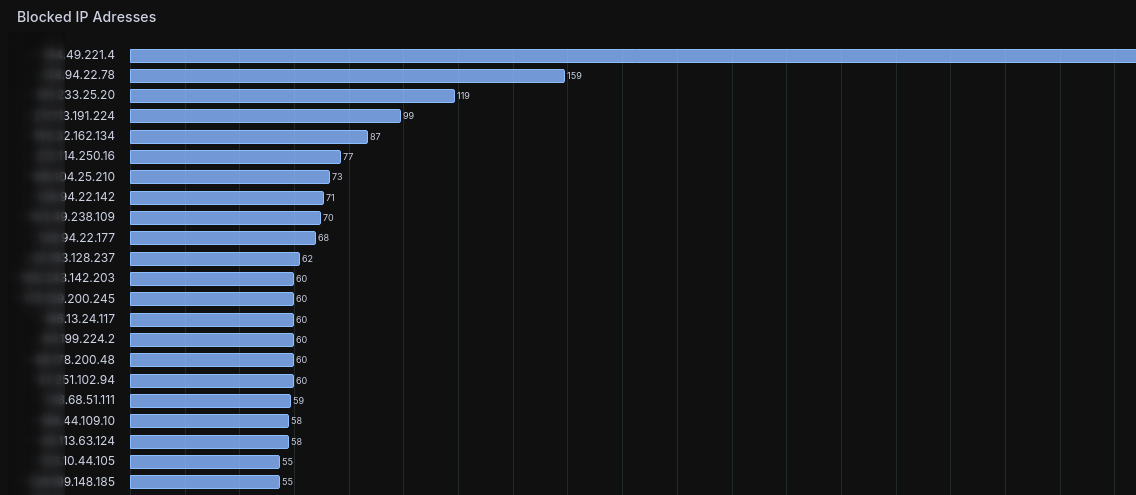

In meinem privaten Scenario habe ich bereits angefangen active-responses durch KI auszulösen. So können künftig Angreifer blockiert werden, auch wenn für den konkreten Angriff noch kein Use-Case geschrieben wurde.

Die Verteidigungsstrategie muss sich daher allgemein zwingend anpassen.

- Automatisierte Verteidigung: KI-gestützte Systeme sind unerlässlich, um Anomalien in Echtzeit zu erkennen und abzuwehren. Ein Security Operations Center (SOC) der Zukunft wird stark auf KI setzen, um die Flut an Ereignissen zu bewältigen und Bedrohungen autonom zu neutralisieren.

- Proaktive Härtung: Systeme müssen von Grund auf gehärtet werden. Wenn eine KI eine bekannte Schwachstelle ausnutzen kann, war das System bereits zuvor unzureichend geschützt.

- Red Teaming mit KI: Unternehmen können eigene KI-Agenten nutzen, um ihre Systeme kontinuierlich auf Schwachstellen zu überprüfen. So kämpft man mit den gleichen Waffen und deckt Lücken auf, bevor es ein Angreifer tut.

Die größte Herausforderung wird sein, mit der Geschwindigkeit und Anpassungsfähigkeit der angreifenden KI Schritt zu halten.

Der Fokus muss sich von der reinen Abwehr bekannter Bedrohungen hin zur Vorhersage und proaktiven Neutralisierung potenzieller Angriffsvektoren verlagern, wie ich es in früheren Blogposts begonnen habe.

Fazit

Die Fähigkeit von LLMs, autonome Cyberangriffe zu orchestrieren, ist ein Paradigmenwechsel in der IT-Sicherheit. Es unterstreicht die Notwendigkeit, die Verteidigungsmechanismen dringend zu überdenken und massiv in KI-gestützte, automatisierte Sicherheitstechnologien zu investieren. Die Zukunft der Cybersicherheit wird ein Wettrüsten zwischen angreifenden und verteidigenden KIs sein. Wir werden sicherlich sehen, wie schnell sich die deutsche Bürokratie anpassen kann...