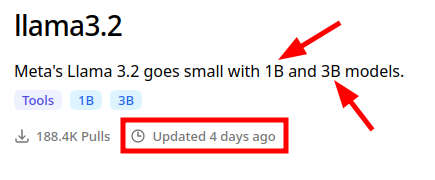

Llama 3.2 small models

Superschnelle lokale KI mit llama3.2

Als vor vier Tagen Llama 3.2 veröffentlicht wurde, habe ich mehr oder weniger darüber hinweggelesen. Doch vor zwei Tagen habe ich es einfach mal gestartet und...

Ich bin begeistert! Denn hier handelt es sich um sehr kleine Modelle:

Zugegeben: Das Modell llama3.2:1b macht einige Fehler. Sowohl grammatisch als auch inhaltlich. Man kann es also nur für unwichtige Dinge gebrauchen.

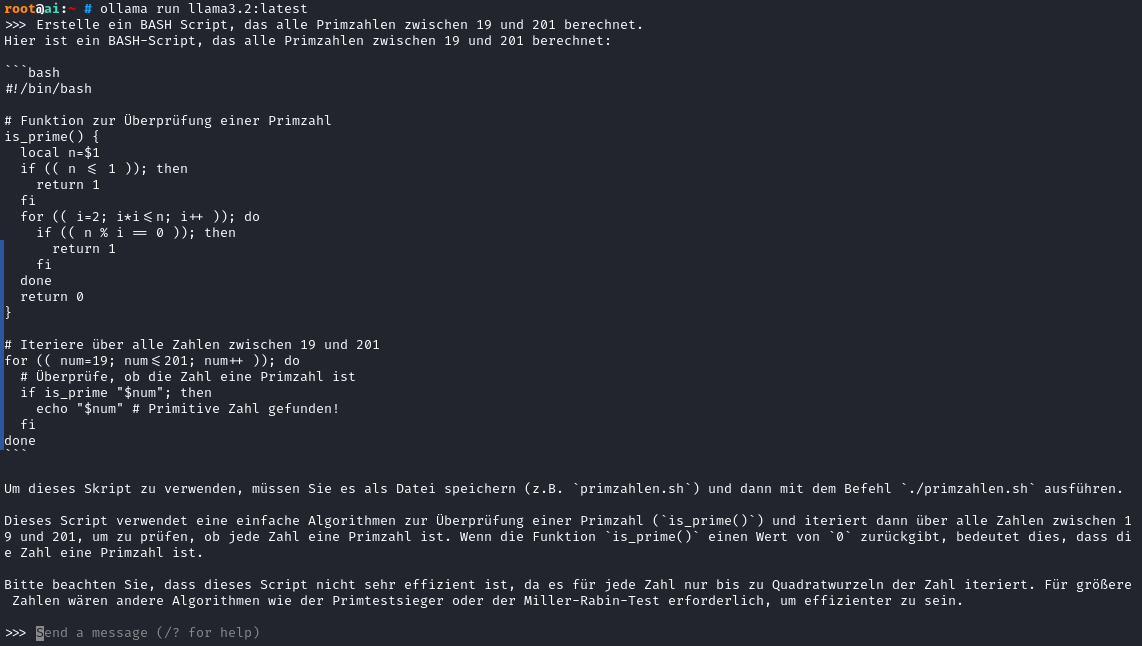

Das 3B Modell hingegen kennt nicht nur die englische Sprache, sondern auch Deutsch. Auch technische Fragen werden vernünftig beantwortet:

Auch die Geschwindigkeiten sind beeindruckend. Und die bisher getesteten Aufgaben wurden erstaunlicherweise von llama3.2:3b am Besten erledigt. Die einzige Anpassung, die ich für größere Probleme vornehmen musste, war die Kontextgröße.

Fazit

Llama3.2:3b wird wohl mein neuer Standard für verschiedene Tools, die ich nutze: Second Brain unter Obsidian oder Companion. Auch mein Signal-Bot wird künftig llama3.2 nutzen, da es offensichtlich alle Fragen meiner Bekannten beantworten kann. Wie die Zusammenarbeit mit Fabric aussieht, muss ich noch testen. Aber ein neuer Blogbeitrag über Companion ist bereits in Vorbereitung...