KI-Agenten lokal im Browser nutzen

Kostenlose, quelloffene KI-Webautomatisierung

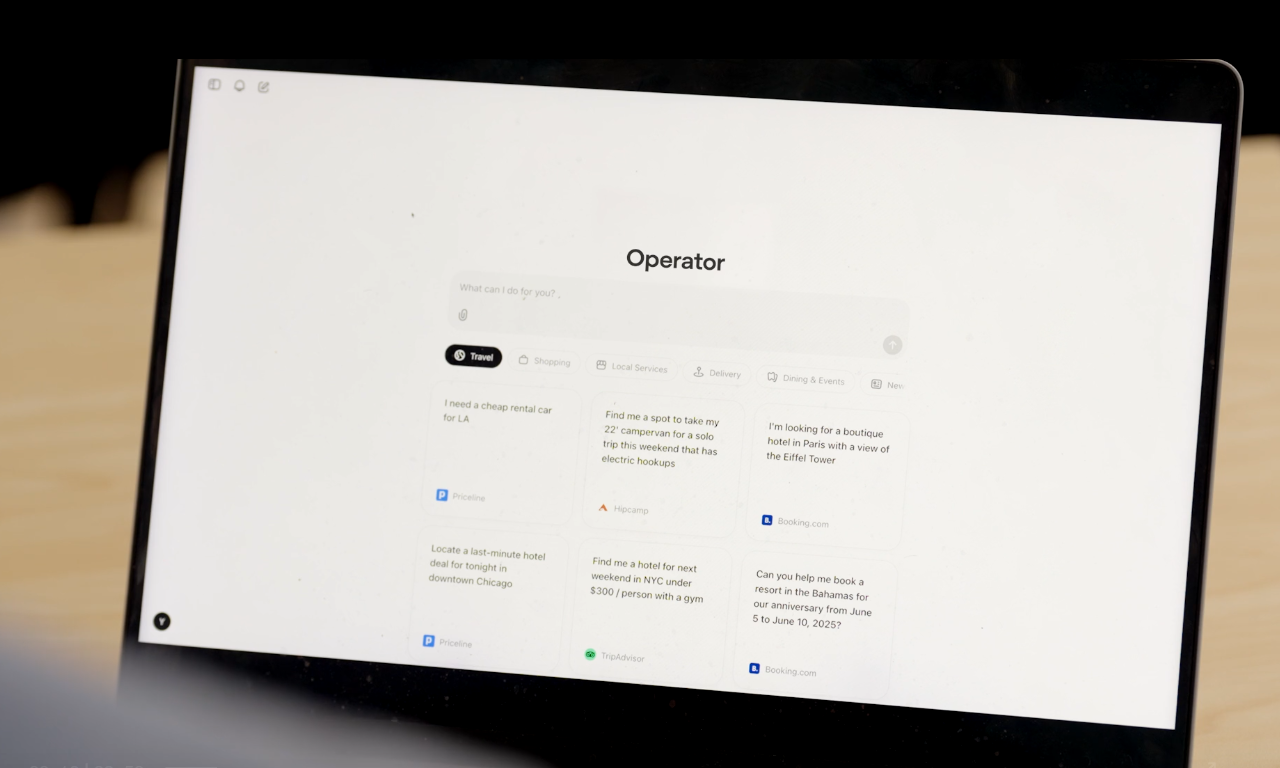

Ich habe vor einiger Zeit über ChatGPTs Operator und seine kostenlose OpenSource Alternative Browser-Use berichtet.

Einigen war die Installation dieser Lösung zu kompliziert. Doch nun gibt es diese KI-Browser-Automation auch als Browser-Extension. Und man kann sich entscheiden, ob man seine datenschutzfreundliche lokale KI nutzen möchte oder die kostenlose KI von Google, über die ich ebenfalls vor kurzem schrieb:

Chrome-Extension

Nanobrowser präsentiert sich als eine quelloffene Alternative zu kommerziellen AI Web-Automatisierungstools, wie beispielsweise dem OpenAI Operator. Die Kernidee ist es, anspruchsvolle Web-Workflows mithilfe von künstlicher Intelligenz direkt im lokalen Browser des Nutzers auszuführen. Dabei setzt Nanobrowser auf ein System spezialisierter KI-Agenten, die zusammenarbeiten, um gestellte Aufgaben zu erledigen. Da alles lokal abläuft, verbleiben Anmeldeinformationen und persönliche Daten sicher beim Anwender und werden nicht an Cloud-Dienste Dritter gesendet.

Vorteile

Es gibt einige überzeugende Gründe, Nanobrowser in die engere Wahl zu ziehen, wenn es um KI-gestützte Webautomatisierung geht:

- 100% Kostenlos: Es fallen keine Abonnementgebühren oder versteckte Kosten an. Man verwendet einfach die eigenen API-Schlüssel der bevorzugten LLM-Anbieter und bezahlt somit nur die tatsächliche Nutzung.

- Datenschutzfokus: Alle Operationen finden lokal im Browser statt. Anmeldedaten und sensible Informationen verlassen niemals den eigenen Rechner.

- Flexible LLM-Optionen: Es besteht die Freiheit, sich mit verschiedenen LLM-Anbietern zu verbinden und unterschiedliche Modelle für die verschiedenen Agenten (Navigator, Planner, Validator) zu konfigurieren. Unterstützt werden unter anderem OpenAI, Anthropic, Gemini, Ollama, Groq, Cerebras und benutzerdefinierte OpenAI-kompatible Anbieter.

- Vollständig Open Source: Der Quellcode auf GitHub ist komplett einsehbar, was für volle Transparenz sorgt. Es gibt keine Black Boxes oder versteckte Prozesse.

Installation aus dem Chrome Web Store (Stabile Version)

Der wohl einfachste Weg führt über den offiziellen Chrome Web Store.

- Die Nanobrowser-Seite im Chrome Web Store aufrufen.

- Auf den Button "Zu Chrome hinzufügen" klicken.

- Die Installation bestätigen.

- Fertig!

Es ist zu beachten, dass die Version im Chrome Web Store aufgrund des Überprüfungsprozesses möglicherweise nicht immer die allerneuesten Funktionen enthält.

Das richtige LLM-Modell für jeden Agenten

Nanobrowser erlaubt die Konfiguration verschiedener LLM-Modelle für jeden Agenten, um eine Balance zwischen Leistung und Kosten zu finden. Hier einige empfohlene Konfigurationen:

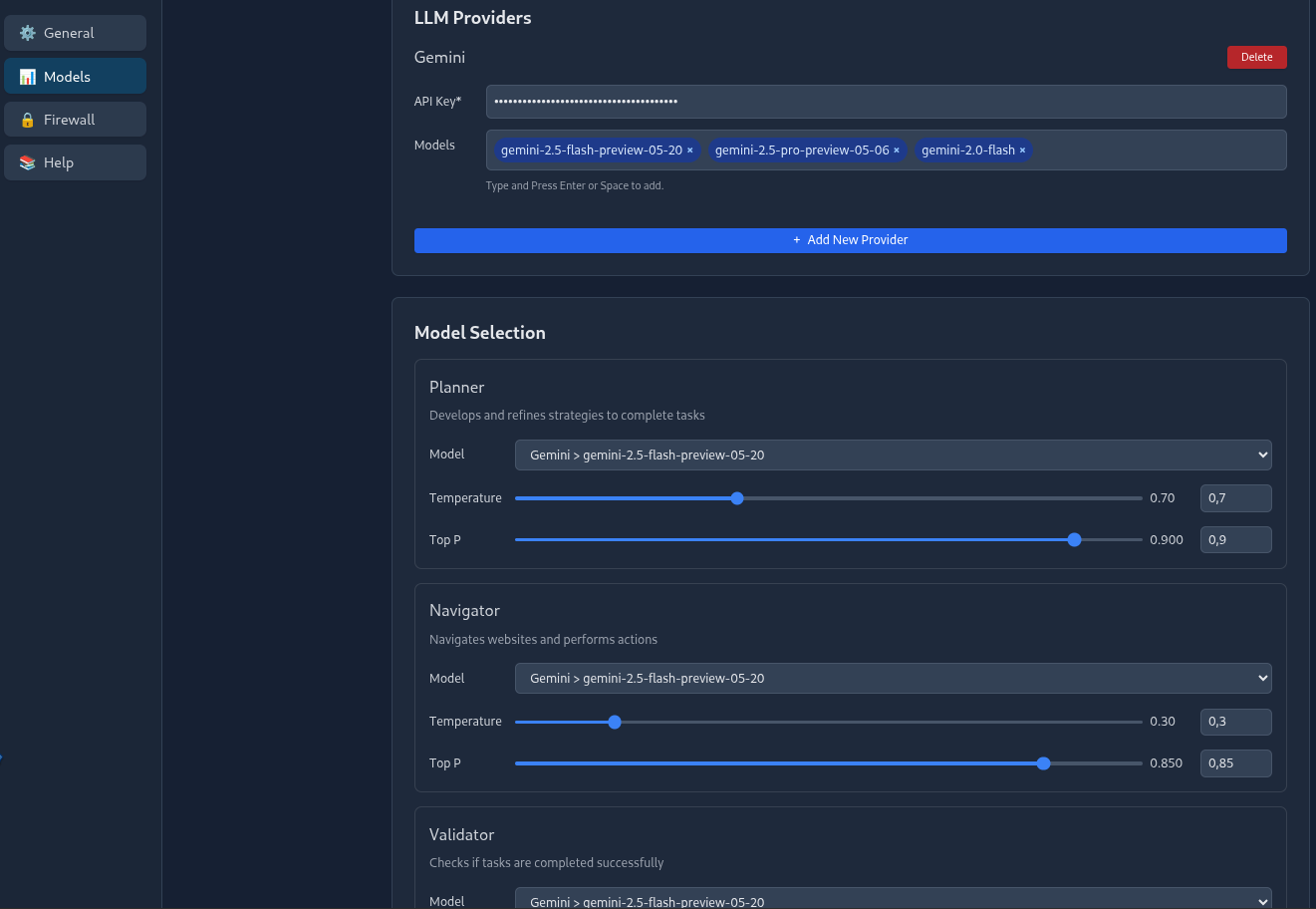

Nutzung der kostenlosen Gemini-API

- Setup-Optionen:

- Verwendung von Gemini.

- Empfohlene Modelle:

- Planner: Gemini-2.5-pro-preview-05-06

- Navigator: Gemini-2.0-flash

- Validator: Gemini-2.5-pro-preview-05-06

Nutzung lokaler Modelle

- Setup-Optionen:

- Verwendung von Ollama oder anderen benutzerdefinierten OpenAI-kompatiblen Anbietern, um Modelle lokal auszuführen.

- Keine API-Kosten und vollständiger Datenschutz, da keine Daten den eigenen Rechner verlassen.

- Empfohlene Modelle:

- Qwen3 14B

- Falcon3 10B

- Qwen 2.5 Coder 14B

- Mistral Small 24B

- Erfahrungsaustausch zu weiteren lokalen Modellen ist in der Discord-Community willkommen.

- Prompt Engineering:

- Lokale Modelle erfordern spezifischere und sauberere Prompts.

- Vermeidung von allgemeinen, mehrdeutigen Anweisungen.

- Zerlegung komplexer Aufgaben in klare, detaillierte Schritte.

- Bereitstellung von explizitem Kontext und Einschränkungen.

Konkrete Anwendungsbeispiele

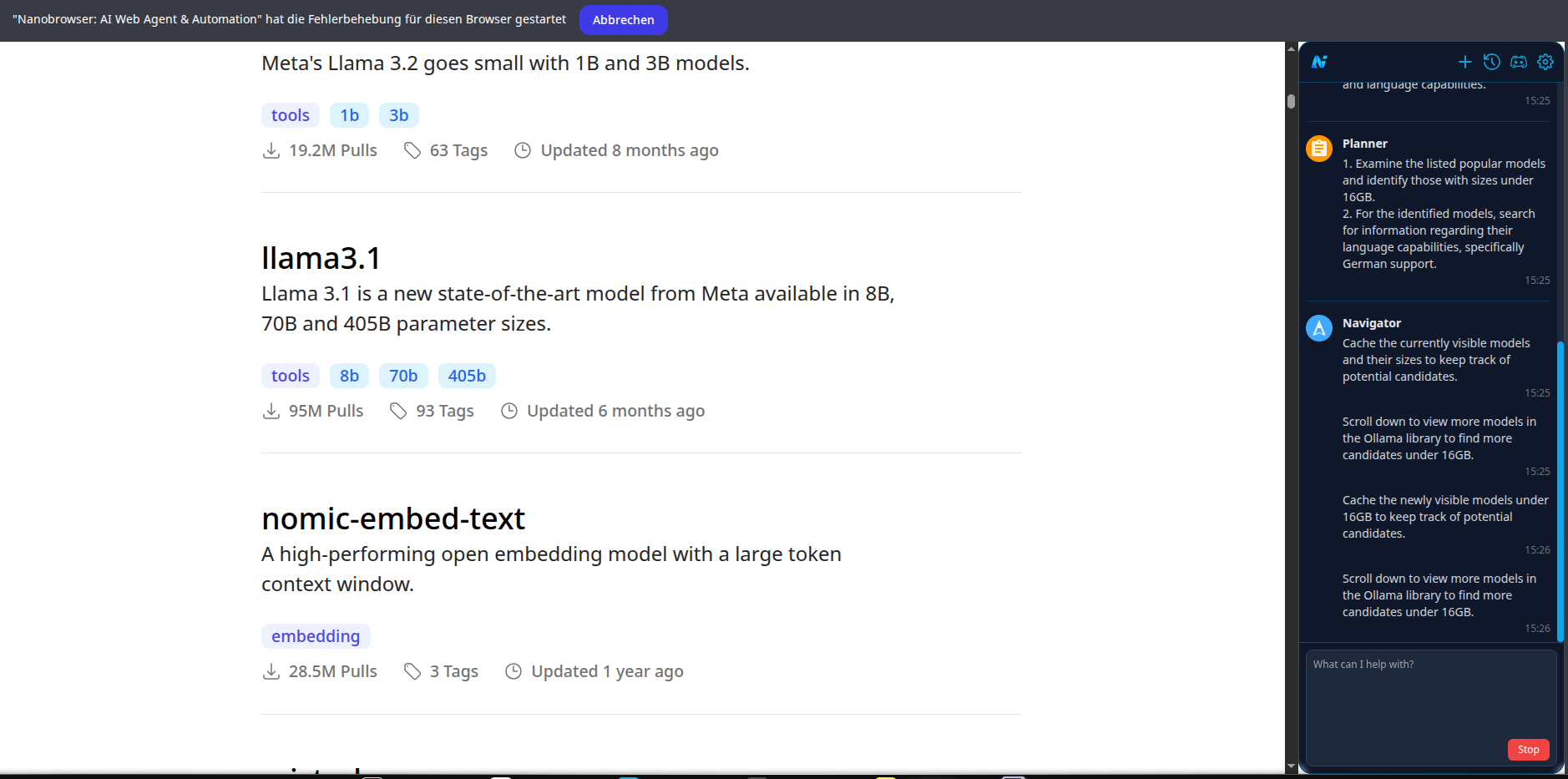

Mit Nanobrowser lassen sich auch komplexe Aufgaben mit nur einem Satz erledigen:

Suche nach der besten lokalen KI, die auf meinem Server lauffähig ist:"Was ist die beste KI, die weniger als 16GB groß ist und in deutscher Sprache kommuniziert?"

Antwort: ✅ Das meistgenutzte Model, das mit Ollama läuft, kleiner als 16GB ist und in deutscher Sprache kommuniziert, ist Llama3-8B (speziell die Version 'DiscoResearch/Llama3-German-8B'). Es ist 4.7GB groß und wurde auf Deutsch spezialisiert.

Fazit

Nanobrowser etabliert sich als eine vielversprechende, kostenlose und quelloffene Lösung für die KI-gestützte Webautomatisierung direkt im Browser. Durch den Fokus auf Datenschutz, flexible LLM-Anbindungen und ein transparentes Multi-Agenten-System bietet es eine attraktive Alternative zu etablierten, oft kostspieligen Diensten.